人工智能工程技术 数据处理与存储服务的核心支柱

在当今数字化浪潮中,人工智能工程技术作为引领未来的关键技术领域,正以前所未有的速度重塑各行各业。其中,数据处理与存储服务不仅是AI技术的基石,更是其从理论走向实践、从实验室走向产业应用的生命线。本文将深入探讨人工智能工程技术中数据处理与存储服务的关键角色、核心技术及其未来发展趋势。

一、数据处理:AI系统的“智慧之源”

数据处理是人工智能工程技术的首要环节,其质量直接决定了AI模型的性能上限。在AI项目中,数据处理服务通常涵盖数据采集、清洗、标注、增强与管理全流程。

- 数据采集与汇聚:现代AI系统需要海量、多源、异构的数据作为“养料”。这包括来自物联网设备的传感器数据、社交媒体中的文本与图像、企业内部的业务日志等。专业的数据处理服务能够通过爬虫技术、API接口、数据交换协议等方式,高效、合规地汇聚这些分散的数据资源。

- 数据清洗与预处理:原始数据往往包含噪声、缺失值与不一致信息。数据处理服务通过自动化脚本与人工审核相结合的方式,进行去重、纠错、格式化与归一化操作,确保数据质量满足模型训练要求。例如,在计算机视觉领域,这可能涉及图像去噪、尺寸统一与色彩空间转换。

- 数据标注与增强:对于监督学习与半监督学习模型,高质量标注数据至关重要。专业服务提供方会建立科学的标注体系,通过众包平台或专业团队,对图像、语音、文本等进行精准标注。通过数据增强技术(如旋转、裁剪、添加噪声等),在有限数据基础上生成更多训练样本,提升模型泛化能力。

二、数据存储:AI资产的“数字仓库”

随着数据规模从GB级向TB、PB乃至EB级跃迁,高效、可靠、可扩展的数据存储服务成为AI工程化的基础设施。

- 分层存储架构:针对AI数据生命周期不同阶段(热数据、温数据、冷数据)的访问频率与性能要求,现代存储系统采用分层设计:

- 高性能存储层:基于NVMe SSD或高速内存,用于存放频繁访问的训练数据集与模型参数,保障低延迟读写。

- 容量存储层:采用分布式文件系统(如HDFS、Ceph)或对象存储(如AWS S3、阿里云OSS),提供海量原始数据与历史结果的低成本存储。

- 归档存储层:使用磁带库或蓝光存储,对极少访问的合规性数据提供长期保存方案。

- 数据湖与数据仓库:

- 数据湖:以原始格式存储结构化、半结构化和非结构化数据,支持数据科学家灵活探索与分析,是AI项目早期数据挖掘的理想环境。

- 数据仓库:存储经过清洗、建模的结构化数据,为BI分析与模型部署提供高质量输入,两者结合形成从原始数据到智能洞察的完整链路。

- 存储与计算分离架构:云原生时代,存储与计算解耦成为趋势。通过高速网络(如InfiniBand、RoCE)连接独立扩展的存储集群与计算集群,既避免了“存储墙”瓶颈,又提升了资源利用率与成本效益。

三、核心技术融合:驱动AI工程化落地

数据处理与存储并非孤立环节,其与AI技术栈的深度融合正催生新一代工程范式:

- 向量数据库的兴起:为高效处理AI模型生成的高维向量嵌入(如文本、图像语义向量),向量数据库(如Milvus、Pinecone)提供近邻搜索、相似度匹配等能力,成为推荐系统、语义搜索等应用的核心组件。

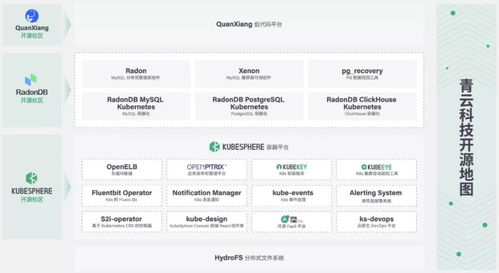

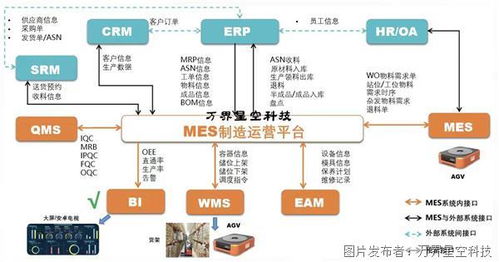

- 数据流水线自动化:通过Airflow、Kubeflow等工具构建自动化数据流水线,实现从数据摄取、转换、模型训练到部署监控的全流程编排,大幅提升AI项目迭代效率。

- 隐私计算与合规存储:在数据安全与隐私保护法规(如GDPR、个人信息保护法)约束下,联邦学习、差分隐私、同态加密等技术,与安全存储方案结合,确保数据“可用不可见”,推动AI在金融、医疗等敏感领域的合规应用。

四、未来展望:智能化、绿色化与边缘化

- 数据处理的智能化:AI技术正反哺数据处理自身。通过主动学习优化标注样本选择,利用GAN生成合成数据,或借助NLP自动解析非结构化文档,数据处理过程将越来越自动化、智能化。

- 存储系统的绿色革命:面对AI算力能耗挑战,存储系统将通过硬件加速(如DPU)、数据压缩与去重、冷热数据智能分层等技术,降低单位存储的能耗与碳足迹。

- 边缘数据服务普及:随着物联网与5G发展,大量AI推理将下沉至边缘设备。轻量级数据处理框架与边缘存储节点(如微型数据中心)的结合,将支持智能制造、自动驾驶等场景的低延时、高可靠数据服务。

###

数据处理与存储服务作为人工智能工程技术的基础设施,已从幕后走向台前,成为衡量AI项目成功与否的关键维度。随着数据规模持续爆炸、AI应用场景不断深化,这一领域将需要更多跨学科人才——他们既需精通分布式系统与数据库原理,又要理解机器学习流程与业务需求,以构建更高效、更安全、更智能的数据基石,支撑人工智能技术的持续创新与普惠落地。

如若转载,请注明出处:http://www.yingyunzhifu.com/product/49.html

更新时间:2026-02-24 15:44:53